BT.2020: Der lange Weg zum erweiterten Farbraum

Kaum hat man sich an UHD, Ultra HD, 4K gewöhnt und sogar festgestellt, dass es sich im Grunde um dasselbe handelt, schwirren die nächsten Abkürzungen durch die technische Gemeinde. Neben High Dynamic Range (HDR) ist es vor allem die Bezeichnung BT.2020, die derzeit Verwirrung stiftet. Warum der HDTV-Standard gemäß BT.709 nach wie vor gültig ist, der erweiterte Farbraum in der Praxis noch wenig Sinn macht und zur ITU-Empfehlung BT.2020 weitaus mehr gehört, haben wir hier für Sie zusammengefasst. Neben Panasonic tritt nun insbesondere Samsung mit seinen SUHD-Modellen der 2016er Serie an den Start des Wettstreits um Detailreichtum und Farbvielfalt. Mit der neuen HDR-Technologie kommt wie durch Zauberhand dynamisches Licht in die aktuellen TV-Displays, das neben einer nie dagewesenen Bildtiefe auch eine gigantische Farbenpracht mit sich bringt. Hersteller werben mit „Wide Color Enhancer“ – also der Erweiterung des Farbraums. In aktuellen Geräten ist dieser bereits einstellbar und wird allgemeinhin als BT.2020 oder Rec.2020 bezeichnet. Wir von BUROSCH erhalten seit einigen Wochen zahlreiche E-Mails mit der Frage, warum wir denn nicht endlich unsere Referenz-/Testbilder an ebenjene BT.2020 anpassen.

Inhaltsverzeichnis:

1. Die aktuelle Videonorm heißt: BT.709

2. 4K + HDR ist erst die Hälfte des Weges von BT.2020

3. Phase 1 und 2: UHD-1 (4K)

4. Phase 3: UHD-2 (8K)

5. Istzustand im Jahre 2016

6. Wie sieht die Realität im Einzelnen aus:

7. Wie entstehen Farben?

8. Was ist ein Farbraum?

9. Folgende Farbraumodelle gibt / gab es

10. DCI: Farbdynamik-Standard für Kinoformate

11. Die Versprechen der Hersteller

12. Probleme zwischen Aufnahme und Wiedergabe

13. Die Zukunft ist noch nicht heute

14. BUROSCH TV Testbilder sind eine visuelle Referenz

15. Fazit:

1. Die aktuelle Videonorm heißt: BT.709

Die Frage ist grundsätzlich leicht zu beantworten: Weil die derzeit gültige Videonorm eben immer noch BT.709 heißt und der erweiterte Farbraum gemäß BT.2020 in der Display-Praxis noch längst nicht angekommen ist. Die Firma BUROSCH ist seit nunmehr siebzig Jahren am Markt und hat so einige Hypes und technische Revolutionen hautnah miterlebt. Einige davon haben sich durchgesetzt (Full HD), andere sind noch dabei (HDR) und wieder andere verschwinden so langsam wieder von der Bildfläche (3D). Insofern gehört es zu unserem Firmenprofil, die technischen Entwicklungen und Trends am Markt genau zu beobachten, im Labor daran teilzuhaben, darüber zu berichten und im richtigen Moment entsprechend zu handeln. Aufgrund unserer engen Zusammenarbeit mit diversen Herstellern sitzen wir quasi in der ersten Reihe, wenn es um die Geburt, die Kinderkrankheiten und die Etablierung eines neuen Features geht.

2. 4K + HDR ist erst die Hälfte des Weges von BT.2020

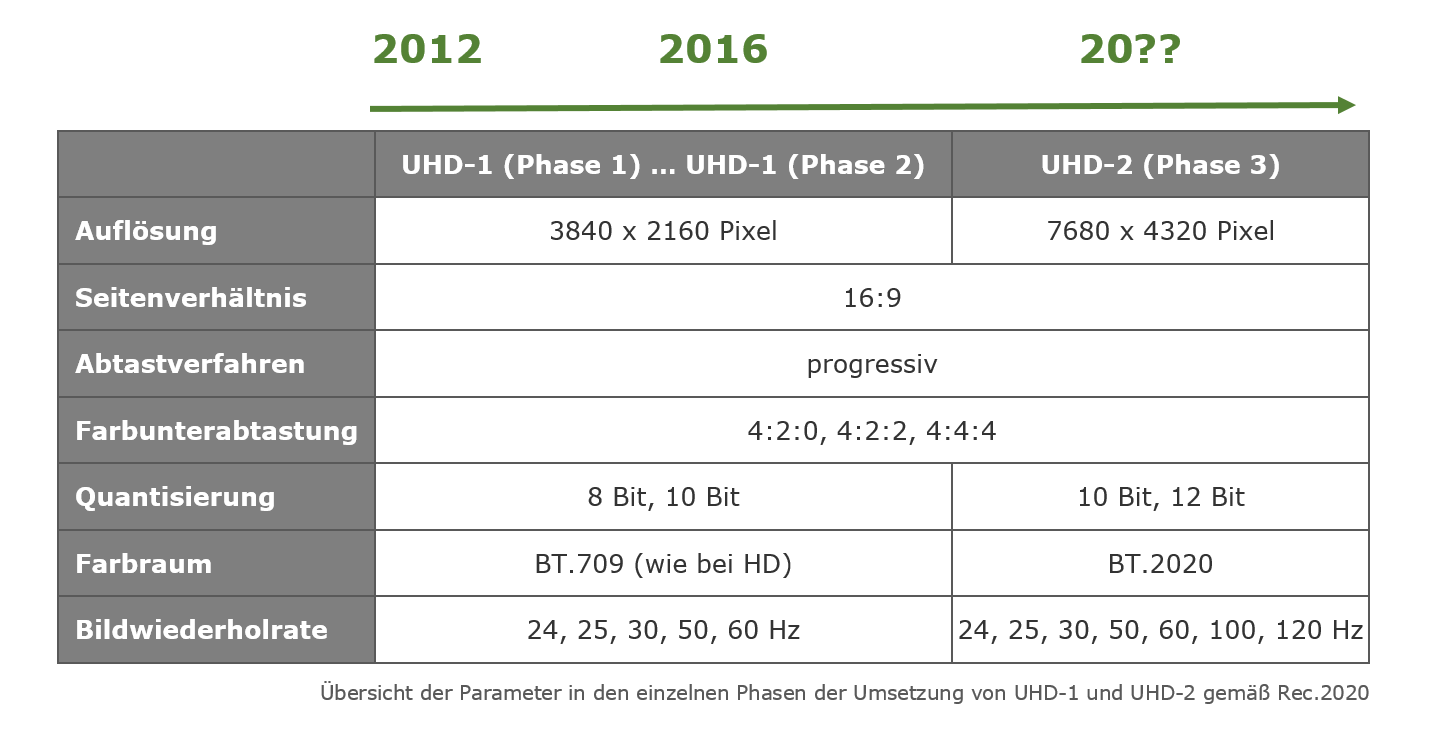

Insofern können wir behaupten: Ja, da tut sich was in punkto Farbraumerweiterung. Die Fernsehtechnik erlebt eine komplett neue Ära. Mit der Recommendation ITU-R BT.2020 vom 23. August 2012 wurde der Grundstein für farbgewaltige XXL-Displays mit beeindruckender Bildqualität gelegt. Aber eben nur der Grundstein und längst nicht die Spitze des gigantischen Wolkenkratzers. Vergleicht man die Entwicklung von High Definition mit einem Hausbau, so befinden wir uns heute vielleicht im mittleren Stockwerk. Denn die BT.2020 sieht insgesamt drei Phasen der Einführung von UHD vor und hat für ebendiese verschiedene Parameter festgelegt oder vielmehr als Mindeststandard empfohlen. Mit 4K und HDR befinden wir uns derzeit am Anfang von Phase 2. Das Ziel von Rec.2020 ist also noch längst nicht erreicht, denn das heißt: 8K.

3. Phase 1 und 2: UHD-1 (4K)

Auflösung: 3840 x 2160 Pixel (viermal so groß wie Full HD, deshalb auch 4K)

Seitenverhältnis: 16:9

Pixel: quadratisch, im Verhältnis von 1:1

Abtastverfahren: progressiv

Bildwiederholrate: 24, 25, 30, 50 oder 60 Hz

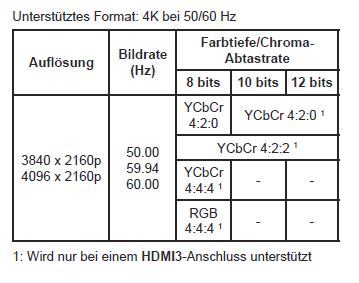

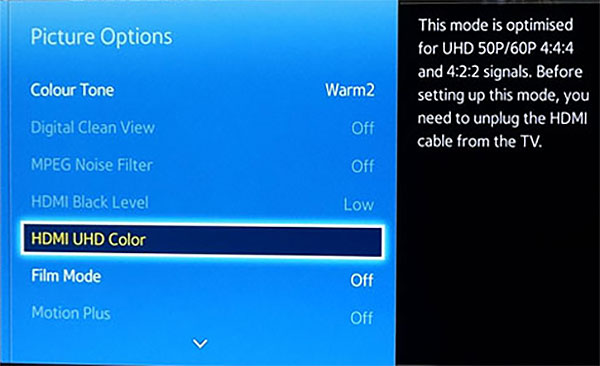

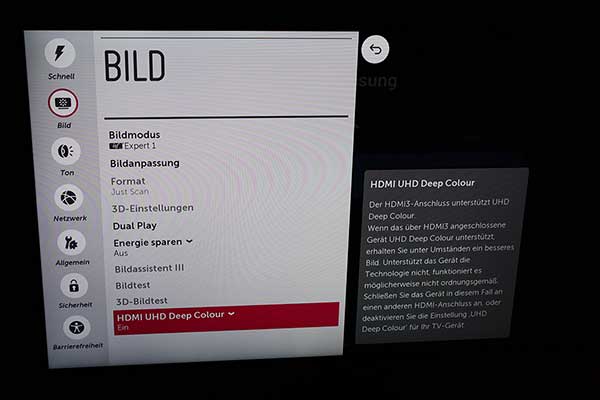

Farbunterabtastung: 4:2:0, 4:2:2 oder 4:4:4

Quantisierung: 10 Bit für Produktion (1024 Stufen pro Farb- und Helligkeitskanal)

8 Bit für Verteilung (256 Stufen pro Farb- und Helligkeitskanal)

Farbraum: identisch mit BT.709

4. Phase 3: UHD-2 (8K)

Auflösung: 7680 x 4320 Pixel (achtmal so hoch wie Full HD, deshalb auch 8K)

Seitenverhältnis: 16:9

Pixel: quadratisch, im Verhältnis von 1:1

Abtastverfahren: progressiv

Bildwiederholrate: 24, 25, 30, 50, 60, 100 oder 120 Hz

Farbunterabtastung: 4:2:0, 4:2:2 oder 4:4:4

Quantisierung: 10/12 Bit (pro Farb- und Helligkeitskanal)

Farbraum: erweiterter Farbraum

5. Istzustand im Jahre 2016

Vier Jahre nach der Veröffentlichung der Rec.2020 befinden wir uns im Jahre 2016 am Anfang der Phase 2 von UHD-1. Das heißt, der Weg bis zur Vollendung der ITU-Empfehlung ist noch lang. Und auch wenn „lang“ im rasanten Tempo der technischen Fortschritts im 21. Jahrhundert quasi nur noch ein Wimpernschlag bedeutet, heißt das dennoch, dass zumindest einige Jahr vor uns liegen, bis HDR und auch der erweiterte Farbraum flächendeckend in den heimischen Wohnzimmern angekommen ist. Denn gerade mit dem schleppenden Breitbandausbau ist das Datenvolumen eines erstklassigen 4K-Streams inklusive HDR & Co. trotz bester Komprimierungsverfahren riesig und kann nach heutigem Stand kaum transportiert werden.

6. Wie sieht die Realität im Einzelnen aus:

Auflösung: Deutschland schafft gerade erst das analoge Kabelfernsehen ab. TV-Inhalte in Full HD sind noch längst nicht flächendeckend verfügbar. Lediglich Videoproduktionen in Ultra HD kommen langsam auf den Markt. Die Entwicklung der 4K-Blu-ray-Disk/-Player hinkt. Mit HDR und einem erweiterten Farbraum können ultrahochauflösende Videoinhalte derzeit praktisch nur per Onlinestream geschaut werden – jedoch in voller Qualität nur von dem, der über Highspeed-Internet verfügt. Bei schwachem Datentransfer (z.B. DSL) wird auf Full HD oder gar SD gedrosselt.

Abtastverfahren/Bildwiederholungsrate: die Öffentlich-Rechtlichen senden derzeit mit 720 Zeilen und 50 Vollbildern pro Sekunde (720p/50) im progressiven Vollbildverfahren. Das Interlaced-/Halbbildverfahren ist jedoch mit 1080i noch nicht vom Tisch der Programmanbieter. Die Zukunft heißt 1080p/50 und damit gerade einmal Full HD und 50 Hz. Das heißt, Ultra HD mit 100/120 Hz (High Frequency Rate: HFR) ist im Zusammenhang mit der TV-Übertragung reine Zukunftsmusik.

Quantisierung/Farbraum: Mit 8 Bit für die Übertragung bzw. Verteilung von TV- und Videoinhalten ist kein HDR möglich. Abgesehen davon sind alle Geräte, die bis 2015 hergestellt wurden, in der Lage, maximal mit 8 Bit zu arbeiten. Der erweiterte Farbraum wird in den Studios generell noch nicht angewendet, aktueller Standard bleibt nach wie vor der Farbraum nach BT.709.

7. Wie entstehen Farben?

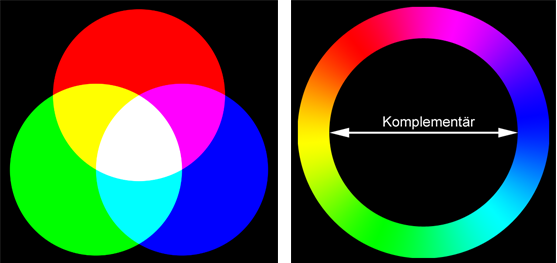

Grundlage für alle Farbräume bieten die Graßmannschen Gesetze, welche die Farbvalenz als eine dreidimensionale Größe - die Grundfarbe (Spektralfarbe), die Farbintensität und die Weißintensität - definieren. Darauf aufbauend werden diese drei Grundgrößen heute im Zusammenhang mit dem HSV-Farbraum, den CIE-Primärvalenzen oder den Werten CMY und RGB verwendet. RGB ist die Abkürzung für Rot, Grün, Blau. Diese drei Farbwerte stellen die Primärvalenzen beziehungsweise Primärfarben dar, also jene drei spektral reinen Farben, die sich nicht aus den jeweils anderen herstellen (mischen) lassen.

Wer schon einmal mit einem Grafikprogramm gearbeitet hat, kennt diese Farben aus der Praxis und weiß, dass sie sich beliebig mischen lassen. Wird der Farbwert eines Objektes auf null gesetzt, färbt sich dieses schwarz. Werden alle drei Farbwerte (R = B = G) gleichmäßig um 50 Prozent erhöht, ergibt das die (unbunte) Farbe Grau. Setzt man zwei der drei Farbewerte auf 0 Prozent und die dritte auf 100 Prozent, ergibt sich daraus eine der drei Primärfarben. Werden zwei Farbwerte auf 100 Prozent gesetzt und der dritte bleibt bei null, können so die Farben Cyan (Grün und Blau), Gelb (Rot und Grün) und Magenta (Blau und Rot) additiv gemischt werden. Aus diesen drei sogenannten Sekundärfarben (Cyan, Magenta und Yellow) resultiert der technisch-physikalische Wert CMY. Stellt man alle drei RGB-Werte auf 100 Prozent, erhält man Weiß.

Der deutsche Naturwissenschaftler Hermann Ludwig Ferdinand von Helmholtz erkannte, dass die Farbvalenz durch Farbton, Sättigung und Helligkeit gekennzeichnet ist. So lässt sich die „Farbe“ nach ihrem Helligkeitsanteil (engl. luminance) und der Farbart unterscheiden. Diese setzt sich aus dem durch die Wellenlänge des Lichtes bestimmten Farbton (engl. hue) und der Farbsättigung (engl. saturation) zusammen, die durch den zugemischten Weißanteil entsteht. Insofern ist der Begriff „Farbe“ nicht korrekt. Es müsste vielmehr „Buntheit“ heißen, da die sogenannten Farbnuancen in erster Linie etwas mit der Helligkeit zu tun haben. Im Umkehrschluss verwendet man bei Grauwerten in der Fachsprache die Bezeichnung „unbunte Farben“.

Verschiedene Farbpaare gelten als komplementär. Dazu zählen Blau ↔ Gelb, Rot ↔ Cyan und Grün ↔ Magenta. Da diese aus den Farben RGB resultieren, stellen sie die Basis dar für das CIE-System und andere technische Systeme (z.B. RGB und CMY). Diese sogenannten Komplementärfarben werden auch synonym als Gegenfarben bezeichnet, da sie sich im sogenannten Farbkreis genau gegenüberstehen. Verändert man die Intensität eines Farbtons, ergeben sich pro Farbton etwa 500 unterscheidbare Helligkeiten.

In der modernen Wissenschaft wird das Spektrum als die Gesamtheit aller Linien und Banden bestimmter Frequenzen in einem energiegleichen Strahlungsereignis definiert. In der Physik besteht das sogenannte „weiße“ Licht aus Anteilen aller Wellenlängen des sichtbaren Spektralbereichs und ist somit ein energiegleich gemischtes Licht, das es in dieser perfekten Form allerdings nur in der Theorie gibt. In der Regel ist damit das Sonnenlicht oder Tageslicht gemeint beziehungsweise die Normlichtarten mit ihren unterschiedlichen Farbtemperaturen. Denn Weiß entsteht auch durch Hitze oder vielmehr verschiebt sich das Maximum des Farbspektrums mit steigender Temperatur hin zu kürzeren Wellenlängen. So nehmen wir beispielsweise das Wellenlängengemisch der Sonne als weiß oder zumindest sehr hell wahr, weil die Außentemperatur dieser Gaskugel ca. 6000 °C beträgt, was einer Farbtemperatur von etwa 5800 Kelvin entspricht. Bei bedecktem Himmel verschiebt sich diese Farbtemperatur der Sonne zu höheren Werten (7000 Kelvin), sodass für das sogenannte Norm- oder Referenzlicht D65 namensgebende 6504 Kelvin zugrunde gelegt wurden.

Als Basis dieser Untersuchungen diente von jeher die menschliche Wahrnehmung. Der Mensch kann etwa 200 Farbtöne und ungefähr 20 Millionen Farben unterscheiden. Grundsätzlich ist festzustellen, dass die Farbe als solche eine Empfindungsgröße darstellt und somit generell subjektiven Charakter besitzt. Letztendlich ist es das Licht, welches im menschlichen Auge in Nervenimpulse umgewandelt wird (ähnlich wie in einem Display). Während der Verarbeitung dieser Impulse in nachgeschalteten Hirnstrukturen entsteht eine Empfindung, die allgemeinhin als „Farbe“ bezeichnet wird. Die physikalischen Einheiten im Bereich der Wahrnehmung sind zwar generell messbar, dennoch ist das, was wir als Schärfe, Kontrast, Licht oder Farbe empfinden und einschätzen, vielmehr eine subjektive oder gar emotionale Größe, die parallel zur individuellen Beschaffenheit und Funktionalität des menschlichen Auges sowie Gehirns verläuft. Genau deshalb können Bildeinstellungen am Display oder Beamer immer nur mithilfe von Referenz-Testbildern perfekt optimiert werden – nicht mit starren Einstellwerten.

8. Was ist ein Farbraum?

Und gerade weil die menschliche Farbwahrnehmung rein subjektiver Natur ist, mussten mit der Entwicklung von Farbtechnologien bestimmte Farben als Referenzwerte festgelegt werden. Bereits im Jahre 1931 wurde eine Normfarbtafel entwickelt und von der Internationalen Beleuchtungskommission (Commission internationale de l’éclairage: CIE) in einem Farbbeschreibungssystem definiert: dem CIE 1931. Auch heute noch stellt das CIE 1931 eine international vereinbarte Methode der Farbkennzeichnung dar, um die menschliche Farbwahrnehmung und die physiologisch farbige Wirkung einer wahrgenommenen Strahlung (Farbvalenz) in Relation zu setzen. Sie basiert auf der additiven Farbmischung. Deshalb wird dieses wahrnehmungsbezogene System auch als CIE-Normvalenzsystem bezeichnet, das die Gesamtheit aller vom Menschen wahrnehmbaren Farben umfasst.

Doch wenn Farbe lediglich eine subjektive Wahrnehmung ist, wie wurde daraus eine allgemeingültige Norm? Um eine Vereinheitlichung der Farben zu bewirken, wurden bereits in den 1920er Jahren mehrere Beobachter für die Studien hinzugezogen. Dabei wurde den Probanden eine vorgegebene Farbfläche mit einem Sichtfeld von 2 Grad mittig zur Hauptblickrichtung relativ dicht vor die Augen gehalten. Abgeleitet wurde diese Methode aus der Erkenntnis, dass diese Zone in etwa der höchsten Dichte der farbempfindlichen Rezeptoren im Bereich der Netzhaut entspricht. Allerdings nimmt erst ab einem Winkel von 10 Grad die Zapfendichte im Areal der besten Farbsichtigkeit im Auge ab. Deshalb wurde im Jahre 1964 auf Grundlage des erweiterten Sichtfeldes (10 Grad) das CIE(1964)-Farbsystem entwickelt, wobei die Farbfläche nicht mehr die Größe einer 1-Euro-Münze hatte, sondern der eines A4-Blattes in normalem Betrachtungsabstand von etwa 30 Zentimetern entsprach.

Diese Farbfläche bestand in beiden Versuchsreihen aus einem geteilten Schirm, auf dessen A-Seite eine bestimmte Farbe und auf dessen B-Seite drei Strahler in den Primärfarben Rot, Grün und Blau projiziert wurden, die als Maß der auf der A-Seite vorgegebenen Lichtfarbe benutzt wurden. Dabei war zwar die Helligkeit variabel, aber nicht die definierte Farbe, deren Wellenlänge mithilfe von Farbfiltern festgelegt wurde. Die Beobachter sollten ihrem subjektiven Farbempfinden nach die verschiedenen Farben, die durch Veränderungen der Helligkeitswerte der drei Lichtquellen (B-Seite) entstanden, dem jeweils vorgegebenen Farbeindruck zuordnen.

In der Entwicklungsphase zum Ende der 1920er Jahre verwendeten W. David Wright und John Guild für die Erzeugung der Spektrallinien Quecksilberdampflampen und Interferenzfilter und legten mit deren Hilfe die Farbwerte 546,1 nm (grün) und 435,8 nm (blau) fest. Da sich bei der Farbe Rot (700 nm) kleine Abweichungen der Wellenlänge im Ergebnis weit weniger bemerkbar machten, konnte auf Glühlampen mit einem Farbfilter zurückgegriffen werden. Wobei es in diesem Zusammenhang zu einem anderen Problem kam: Im Bereich der Grün-Blau-Einstellungen konnten von den Beobachtern einige Testfarben nicht vollends übereinstimmend festgelegt werden. Deshalb musste auf der einen Seite rotes Licht zugeführt und auf der anderen Seite weggenommen werden, was im Protokoll als negativer Rot-Wert festgehalten wurde. Grundsätzlich ist allerdings kein Farbdisplay oder Projektor in der Lage, rote Farbe mit negativer Intensität zu erzeugen. Deshalb können Farben im Grün-Blau-Bereich bisweilen nur ungesättigt (zu blass) dargestellt werden.

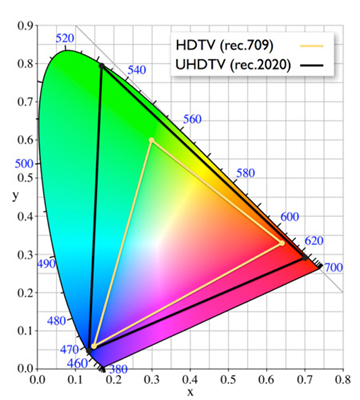

Mithilfe der Dreifarbentheorie gelang somit die numerische Erfassung der vom Menschen wahrnehmbaren Farbreize. Auch wenn die Hufeisenform des CIE-Farbsegels vom Grunde her der nicht-linearen physiologischen Verarbeitung im menschlichen Auge entspricht, können mit den drei Primärfarben nur die Farbreize technisch wiedergegeben werden, die nach dem Gamut-Prinzip innerhalb des abgebildeten Dreiecks liegen. Insofern handelt es sich hierbei um ein theoretisches Dreieck mit einem mathematisch definierten Feld, in dem jeweils die Farben liegen, die von einem Bildgerät reproduziert werden können. Auch wenn sich dieses dreieckige Feld innerhalb des Gamuts im Laufe der Zeit erweiterte und damit heute einen weitaus größeren Farbraum gemäß Rec.2020 zulässt, gleicht es noch längst nicht dem Potenzial der menschlichen Wahrnehmung.

9. Folgende Farbraumodelle gibt / gab es:

- CIE-XYZ Farbraum

- CIE-RGB Farbraum

- NTSC (US TV-Norm)

- PAL (TV/DVD)

- SECAM

- sRGB (Computer/Monitor seit 1996 – aktuelle Alternative zu REC 709 im Bereich HDTV)

- Adobe RGB (seit 1998 internationaler Standard in der Profi-Fotografie)

- Wide-Gamut

- DCI (aktuelle Kinonorm für „Digitalen Film“)

- CMYK (Offsetdruck/Siebdruck/Digitaldruck)

- Rec. 601 alter Standard für PAL, DVD, Video

- Rec. 709 aktueller HDTV-Standard

- Rec. 2020 neuer UHD-Standard

10. DCI: Farbdynamik-Standard für Kinoformate

Neben der Empfehlung der ITU für die Farbräume ist heute noch ein weiterer Farbdynamik-Standard zulässig, der bisher vorwiegend in der digitalen Kinoprojektion verwendet wurde. Es verblüfft insofern nicht, dass dieser Standard vom Dachverband der amerikanischen Filmstudios herausgegeben wurde – genauer gesagt der Digital Cinema Initiatives (DCI). Der entsprechend bezeichnete DCI-Farbraum ähnelt vom Umfang her in etwa dem Adobe-RGB-Farbraum und ist somit bedeutend größer als der Farbraum gemäß BT.709 aber kleiner als nach BT.2020. In diesem Zusammenhang sei darauf hingewiesen, dass sich die 4K-Auflösung ursprünglich auf die Kino-Auflösung (4096 × 2160 Pixel) bezog, jedoch ähnlich wie DCI nunmehr in abgewandelter Form auch im Heimkinobereich Anwendung findet.

Bei der Einführung von UHD-Fernsehern wurden noch 8-Bit-Displays verbaut und somit lediglich der Farbraum nach Rec.709 realisiert. Insofern sind hier die gravierenden Unterschiede in der Bilddarstellung begründet, weshalb die Pixelanzahl eben nicht allein über die Qualität entscheidet. So wurde der Farbraum gemäß der Empfehlung Rec.2020 für UHD-2 erweitert und umfasst 75,8 Prozent der Farben im Diagramm des Farbraumes CIE 1931 und damit Wellenlängen, die nach Rec.709 (35,9 Prozent) noch nicht darstellbar waren. Für die RGB-Grundfarben wurden die folgenden Wellenlängen in der BT.2020 festgesetzt: Rot (630 nm), Grün (532 nm), Blau (467 nm).

Aufgrund der höheren Abstände zwischen benachbarten Farbwerten erfordert die entsprechend höhere Farbpräzision ein zusätzliches Bit pro Abtastwert. Gemäß der ITU-R-Empfehlung BT.2020 wird bei 10 Bits pro Abtastwert eine Helligkeitswerteskala genutzt, bei der der Schwarzpunkt auf den Code 64 und der Weißpunkt auf den Code 940 festgesetzt sind. Für die Zeitreferenz dienen die Codes 0 bis 3 und 1.020 bis 1.023, während die Codes 4 bis 63 Helligkeitswerte unterhalb des Schwarzpunktes und die Codes von 941 bis 1.019 Helligkeitswerte oberhalb des Nennspitzenwertes bezeichnen. Bei 12 Bits pro Abtastwert ist der Schwarzpunkt auf dem Code 256 und der Weißpunkt auf dem Code 3.760 der Helligkeitswerteskala gemäß Rec.2020 festgelegt. Entsprechend verändern sich die übrigen Werte: Zeitreferenz (Codes 0 bis 15 und 4.080 bis 4.095), Helligkeitswerte unterhalb des Schwarzpunktes (Codes 16 bis 255), Helligkeitswerte oberhalb des Nennspitzenwertes (Codes von 3.761 bis 4.079).

11. Die Versprechen der Hersteller

Bei der Fülle dieser Werte ist schnell erkennbar, dass insbesondere bei der Farbreproduktion Schwierigkeiten auftreten können. Auch wenn Studiomonitore (z.B. BVM-L 230 von Sony) über präzise Farbkorrekturen verfügen, die nahezu alle Farbstandards emulieren können, heißt das noch lange nicht, dass auch Consumer-Geräte dazu in der Lage sind. Die Hersteller werben mit „Wide Color Enhancer“ und versprechen bessere und sogar mehr Farben, als die Fernsehtechnik jemals vermochte und die Konkurrenz hat. Tatsächlich ist aber die nicht Anzahl der Farben, sondern deren Darstellung eine andere. Und genau hier liegt der Hase im Pfeffer! Selbst wenn die aktuellen TV-Geräte einen erweiterten Farbraum darstellen können, entspricht dieser nicht immer dem festgelegten Farbstandard. Bei der Reproduktion des Farbraums werden somit Farben schlichtweg falsch dargestellt – also nicht so, wie bei der Aufnahme bzw. Filmproduktion vorgesehen.

Wide-Color-Enhancer-Technologie (Samsung)

12. Probleme zwischen Aufnahme und Wiedergabe

Schon mit der Einführung von HDTV und dem Farbstandard gemäß ITU-R BT.709 gab es Probleme zwischen der Filmaufnahme und der Filmwiedergabe. Während die Koordinaten für die Farborte exakt definiert sind, wurde ein verbindlicher Gammaverlauf nur für die Filmaufnahme festgelegt – nicht aber für die Wiedergabe! Doch die Basis für ein perfektes Bild ist die korrekte Umsetzung der Gammafunktion bzw. Gammakorrektur. Hierbei handelt es sich um das Leuchtverhältnis unterschiedlicher Grau- und Farbstufen, das dazu dient, aus einer linearen Größe (Aufnahme) eine nicht-lineare Übertragungsfunktion (Wiedergabe) zu machen, die der menschlichen Wahrnehmung entspricht.

Im Allgemeinen hat sich der Gammawert von 2,2 bis 2,4 als Standardgröße etabliert, weshalb Displays zwischen 10 und 90 IRE exakt auf ein Gamma von 2,2 kalibriert werden. Bei der Verarbeitung des Eingangs- und Ausgangssignals im TV-Display kann es nun zu Fehlern kommen, die vor allem die Leuchtkraft und damit den Kontrast und natürlich auch die Farbstufen betreffen. Denn der spezifizierte Gammaverlauf von BT.709 für die Aufnahme weicht massiv von einem realen Gamma 2,2 ab. So muss ein 10%-Pegel im Eingangssignal noch längst keine 10 % der maximalen Leuchtkraft bei der Wiedergabe ergeben. Bisweilen bleibt nicht mehr als 1 % Lichtstärke im Ausgangssignal übrig. Dies ändert sich nun insbesondere mit der neuen HDR-Technologie. Denn hier wurde die nicht-lineare Übertragungsfunktion (klassische Gammakurve) durch die weitaus komplexere elektrooptische Transferfunktion (EOTF) ersetzt.

Jedoch definiert die ITU mit BT.2020 weiterhin eine nichtlineare Übertragungsfunktion zur Gammakorrektur bei RGB und YCbCr. Wobei RGB für beste Qualität und YCbCr für die Gewährleistung der Kompatibilität zu SDTV/HDTV eingesetzt werden kann. Darüber hinaus ist in BT.2020 ebenfalls eine linear kodierte Version von YCbCr (YcCbcCrc) definiert, welche Anwendung findet, wenn eine möglichst originalgetreue Reproduktion der Helligkeitsinformationen gefordert wird.

Hinzu kommt, dass neben der Gammakorrektur gemäß BT.2020 bei der Filmproduktion bzw. dem Mastering weitere Übertragungsfunktionen verwendet werden (z.B. nach BT.1886, BT.2035 oder Dolby Perceptual Quantizer: PQ). Außerdem kann im Nachhinein kaum eine eindeutige Aussage darüber getroffen werden, welcher Film wie gemastert wurde.

Kurzum: Fernsehtechnik bedeutet heute nicht mehr nur schlichte Amplitudenmodulation. Die digitale Technik ist mittlerweile so komplex geworden, dass selbst beste Prozessoren ihre Schwierigkeiten bei der Signalverarbeitung haben. Genau deshalb klafft zwischen der Theorie und der Praxis noch eine riesige Lücke, die erst nach und nach gestopft werden kann.

13. Die Zukunft ist noch nicht heute …

Erinnern Sie sich an das Desaster seinerzeit bei der Umstellung auf 16:9? Selbst als die Fernseher technisch dazu in der Lage waren, das Seitenverhältnis automatisch anzupassen, waren nervige Verzerrungen die Folge. Die Darsteller in älteren Filmen oder TV-Produktionen im 4:3-Format hatten plötzlich breite Gesichter oder aber ihnen fehlte der halbe Kopf. Ganz ähnlich verhält es sich bei der Darstellung der beiden Farbräume. Denn es ist nicht so einfach, aus 75,8 Prozent des Farbraums 35,9 Prozent zu zaubern – oder umgekehrt. Vor allem dann, wenn nicht bekannt ist, wie diese Farben produziert wurden. Anders als beim Upscaling/Downscaling – also der Anpassung von Full HD auf Ultra HD oder umgekehrt - gibt es in punkto Farbraum kaum keine geeignete Technologien, die es ermöglichen, die Farben bzw. Farbstandards automatisch anpassen zu können. Die ersten Geräte bieten bereits in den Bildeinstellungen die Auswahlmöglichkeit zwischen BT.709 und BT.2020. Nur hilft uns dieser Modus zurzeit noch keinen Millimeter weiter. Denn auch mit dem teuersten Fernseher bleiben die massiven Probleme in der Abwärtskompatibilität sowie der Linearität der Wiedergabekette bei den verschiedenen Zuspielungen. Warum? Produziert und gesendet wird derzeit noch im Farbraum gemäß BT.709. Stellt man das Display mit BT.2020 ein, wirken die Bilder zu knallig. Und selbst wenn Videomaterial mit dem erweiterten Farbraum zugespielt wird, können die Geräte heute noch nicht automatisch zwischen den Farbräumen wechseln und die Bildmodi entsprechend anpassen. Insofern ist es wohl für den Übergang besser, weniger Farben einzustellen, auch wenn man mehr Farben zur Verfügung hat.

Gerade in den letzten Wochen erreichten uns zahlreiche E-Mails von stolzen Besitzern eines 2016er UHD-Fernsehers. Alle Anfragen hatten eines gemeinsam: „Warum gibt es noch keine Testbilder für HDR und BT.2020? Solange es keine Testbilder für den erweiterten Farbraum gibt, warte ich lieber noch mit dem Kauf.“ Kann man machen. Muss man aber nicht! Also, abwarten und Tee trinken. Denn die Frage ist: Warum fällt es manchen Menschen einerseits so verdammt leicht 4.000 oder auch „nur“ 2.000 Euro für ein Premium-TV-Modell auszugeben und andererseits so verdammt schwer, noch weitere 20 Euro in die Bildoptimierung zu investieren? Natürlich kann es sein, dass sich in einem Jahr der Markt bereits so weit entwickelt hat, dass HDR und der erweiterte Farbraum nach BT.2020 keine Utopie mehr darstellen.

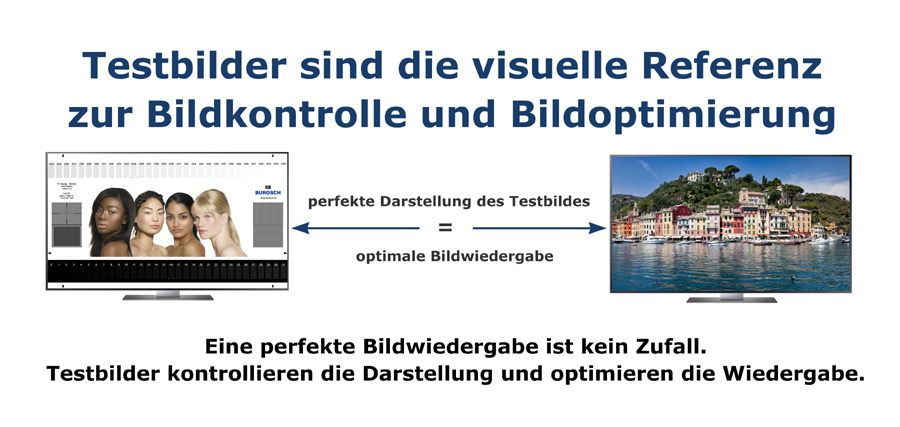

14. BUROSCH TV Testbilder sind eine visuelle Referenz

Unsere Testbilder sind eine visuelle Referenz – ähnlich wie das Urmeter oder die Atomuhr zur richtigen Zeiteinstellung. Mithilfe unserer Referenz Testbilder regeln Sie also die Werte in den Grundeinstellungen soweit, bis alle Testbereiche richtig angezeigt werden. Das heißt also, werden unsere Testbilder perfekt dargestellt, gelingt auch die korrekte Wiedergabe des Videomaterials. Zudem werden derzeit und in naher Zukunft Videoinhalte ausschließlich mit dem aktuellen Farbraum (BT.709) produziert, übertragen, empfangen, verarbeitet und wiedergegeben.

Natürlich versprechen die aktuellen TV-Modelle den erweiterten Farbraum. Die ITU-Empfehlung BT.2020 bezieht sich jedoch nicht auf die Bildeinstellungen, sondern grundsätzlich auf die Display-Technik für ultrahochauflösende Geräte. Es geht also primär um Bit, Hertz und die technischen Voraussetzungen für die Zukunft von UHD-2 (8K). Deshalb ist vieles davon noch längst nicht Realität. Bis sich die Display-Technik gemäß BT.2020 umfassend auf dem Markt durchsetzt, wird es noch eine Weile dauern. In enger Zusammenarbeit mit diversen Herstellern testen wir erst seit einigen Monaten in der Produktionsphase die Displays auf den aktuellen Farbraum gemäß Rec.2020 - so beispielsweise das UltraHD-Premium-Modell TX-58DXW904 von Panasonic, welches als erstes Gerät überhaupt das Premium-Siegel der UHD-Alliance erhielt und tatsächlich den erweiterten Farbraum darstellen kann und darüber hinaus HDR-fähig ist.

Insofern berücksichtigen wir von BUROSCH selbstredend die aktuellen Empfehlungen der ITU, richten uns bei unseren Testbildern für Privatkunden jedoch nach der aktuellen HD-Videonorm gemäß ITU-R BT.709 (Farbraum RGB 16 bis 235), welche für die Grundeinstellungen eines jeden TV-Gerätes nach wie vor optimal sind. Kurzum: Selbstverständlich sind unsere UHD-Testbilder für die Optimierung der Bildeinstellungen Ihres TV-Gerätes zu gebrauchen, sonst würden wir uns nicht Marktführer nennen und dieses Produkt für Ultra HD/4K anbieten.

15. Fazit:

Selbstverständlich ist ein möglichst großer Farbraum ein wesentliches Qualitätsmerkmal sowohl bei der Aufnahme als auch bei der Wiedergabe. Denn nur ein umfassender Einstell-Spielraum macht eine automatische Farbkorrektur möglich, die dafür sorgt, dass die Farbreproduktion an die unterschiedlichen Farbstandards angepasst werden kann und somit neutrale Farben liefert. Die Frage ist nur, ob sich Hersteller und vor allem Verkäufer hierbei in die Karten schauen lassen bzw. über das nötige Wissen verfügen, um dem aufgeklärten Käufer die nötigen Auskünfte zu geben. Denn auch wenn es noch eine Weile dauern wird, bis Hollywood seine Blockbuster im erweiterte Farbraum produziert, kann es nicht schaden, schon heute einen Fernseher zu besitzen, der nicht nur den aktuellen HDTV-Standard BT.709 korrekt darstellt, sondern darüber hinaus den erweiterten Farbraum gemäß BT.2020 realisieren könnte.

Versüßen Sie sich die Wartezeit bis dahin mit einer perfekten Bildoptimierung nach BT.709 und holen Sie mit BUROSCH das Beste aus Ihrem TV.

Sender, die ihr Programm bereits heute in Ultra HD-Auflösung ausstrahlen (Stand: Januar 2015), die gibt es bis auf den "Astra Ultra HD Demokanal" leider noch keine. Panasonic ist mit ihrer aktuellen

Sender, die ihr Programm bereits heute in Ultra HD-Auflösung ausstrahlen (Stand: Januar 2015), die gibt es bis auf den "Astra Ultra HD Demokanal" leider noch keine. Panasonic ist mit ihrer aktuellen