HDR das Geheimnis des Lichts

Ultra HD ist schon längst in unseren Wohnzimmern angekommen. Nun tauchen neue Schlagwörter auf, die Anwendern einiges Kopfzerbrechen bereiten. Nicht selten werden technische Begriffe wie 4K, HDR und der erweiterte Farbraum in einen Topf geworfen. Fakt ist jedoch, dass jedes dieser technischen Features eine Klasse für sich darstellt. Was bedeutet nun HDR, warum hinkt die Umsetzung und welche Potenziale stecken drin?

Inhaltsverzeichnis:

1. Was bedeutet nun HDR und was steckt wirklich dahinter?

2. Ultra HD (UHD, 4K) heißt noch längst nicht HDR

3. Das Licht ist das Geheimnis von Detailgenauigkeit und brillanter Farbdarstellung

4. Adaption nach menschlichem Vorbild

5. Nicht alle Geräte der 2016er Serie sind tatsächlich HDR-fähig

6. Doch wo Licht ist, ist auch Schatten!

7. Das Problem liegt zwischen Aufnahme und Wiedergabe

8. Tonemapping

9. HDR-Übertragungsmethoden

10. Metadaten

11. HDR-Systeme und ihre verschiedenen Ansätze

12. HDR erst vollkommen mit entsprechend produziertem Videomaterial

13. HDR nur mit dem richtigen Kabel

1. Was bedeutet nun HDR und was steckt wirklich dahinter?

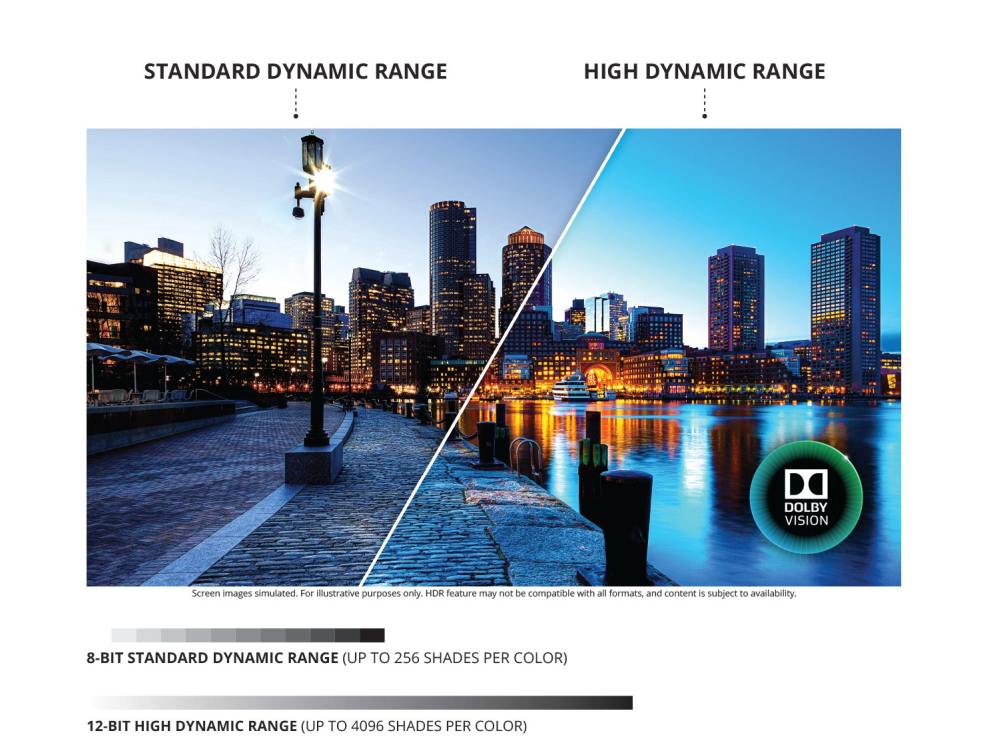

Der hohe Dynamikumfang (High Dynamic Range: HDR) kommt grundsätzlich aus der Bildbearbeitung. Dabei handelt es sich um sogenannte Hochkontrastbilder, die große Helligkeitsunterschiede detailreich wiedergeben, weshalb in diesem Kontext von Bildern mit hohem Dynamikumfang gesprochen wird. Das Gegenteil ist LDR – also digitale Bilder mit geringem Dynamikumfang: Low Dynamic Range. Das Mittelmaß bezeichnet das derzeit gängige SDR (Standard Dynamic Range). Modernes Fernsehen hat spätestens seit 2016 nicht mehr ausschließlich etwas mit Masse zu tun, auch wenn über acht Millionen Pixel pro Bild bei Ultra HD natürlich schon großartig sind. Jetzt werden neben der ultrahohen Auflösung ebenjene Pixel qualitativ aufgemotzt. Die einzelnen Bildinformationen können mithilfe der HDR-Technik aufgewertet werden und machen das Videomaterial somit noch brillanter und detailreicher. Insofern sollte man HDR nicht synonym für Ultra HD verwenden, denn es ist weitaus mehr. Mit HDR wird es zukünftig gigantische 1.000 Helligkeitsabstufungen geben, während bei herkömmlichen UHD/4K-Inhalten lediglich 256 Hell-Dunkel-Werte pro RGB-Farbkanal möglich sind.

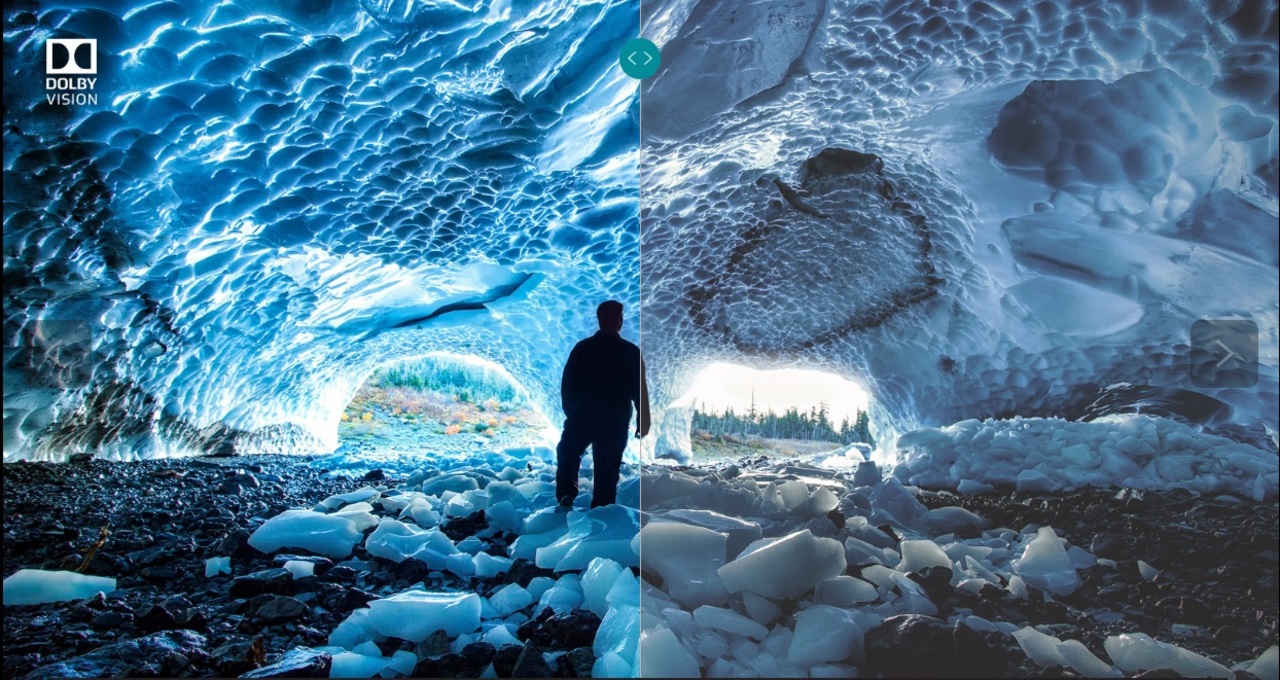

Mit HDR gelingt die Darstellung des gesamten Umfangs an sichtbaren Details – sowohl im Licht als auch im Schatten. Das klingt erst einmal einfach, ist es aber ganz und gar nicht. Wenn Sie beispielsweise ein paar Sekunden in die Sonne schauen, fällt es Ihnen im Anschluss außerordentlich schwer, sich in einem dunklen Keller zu orientieren. Wenn man nun bedenkt, dass die menschliche Wahrnehmung der Technik meilenweit voraus ist, erkennt man, dass die parallele Aufnahme sowie Darstellung von hellen und dunklen Bereichen eine mannigfaltige Herausforderung für Ingenieure und Hersteller ist. Denn bisher konnte man entweder Details im Hellen darstellen, wobei dann im dunklen Teil des Bildes nichts zu erkennen war. Oder eben umgekehrt: bei detailreichen dunklen Szenen wurde der helle Anteil überbelichtet. Mit HDR wird es zukünftig möglich sein, sowohl dunkle als auch helle Bildanteile so zu produzieren und wiederzugeben, wie wir sie in der Natur wahrnehmen und es sich Produzenten und Regisseure wünschen. Dabei wird zwischen diffusem Weiß und sogenannten Spitzlichtern unterschieden, was eine deutlich bessere Differenzierung in der Tiefe eines Bildes zulässt. Das Ergebnis ist eine Bildwiedergabe, die wesentlich naturgetreuer ist, als es bisher möglich war.

2. Ultra HD (UHD, 4K) heißt noch längst nicht HDR

Die vielen Informationen und Werbeversprechen der Hersteller lassen uns glauben, dass HDR nun quasi dazugehört und gleichzusetzen sei mit 4K oder Ultra HD. Auch wir von BUROSCH erhalten immer mehr Anfragen, warum wir noch keine Testbilder in HDR anbieten. Doch letztlich stehen wir hier noch ganz am Anfang, wenngleich die technische Entwicklung schneller voranschreitet als noch im letzten Jahrtausend. Während der sogenannte Dynamikumfang – also das Verhältnis von größter und kleinster Leuchtdichte – noch vor einigen Jahren bei mickrigen 100 Nits lag und Videomaterial in ebenjenem Kontrastverhältnis von 100:1 produziert wurde, lagen die Werte bis 2014/2015 bei etwa 400 Nits. Einige UHD-TVs im Jahre 2016 schaffen hingegen die für HDR erforderliche Spitzenhelligkeit von 1.000 Candela pro Quadratmeter (cd/qm) und ein entsprechendes Kontrastverhältnis von 1000:1 bis stellenweise sogar 10.000:1. Die HDR-Tauglichkeit der Geräte hängt also unmittelbar mit den technischen Voraussetzungen zusammen, die zum einen die erwähnte Spitzenhelligkeit als auch den Schwarzwert betreffen, der im Rahmen der Zertifizierung der UHD Alliance bei weniger als 0,05 Nits für LED-LCD-Displays bzw. unter 0,0005 Nits für OLED-Bildschirme liegt.

Andererseits ist für diesen riesigen Dynamikumfang (0,05 bis 10.000 Nits) und die entsprechend kontrastreiche Darstellung eines unabdingbar: die erhöhte Quantisierung. Das heißt, die Bildabtastung muss in einem höheren Intervall erfolgen, da weitaus mehr Werte im Signal verarbeitet werden müssen. Um diese für HDR typischen hohen Kontraste und brillante Bildqualität erreichen zu können und störende Helligkeitsschwellen bzw. Helligkeitssprünge (Artefakte) unsichtbar zu halten, reicht die bisherige 8-Bit-Technik mit 256 Helligkeitsstufen nicht mehr aus.

3. Das Licht ist das Geheimnis von Detailgenauigkeit und brillanter Farbdarstellung

Gemäß des neuen Standards (SMPTE ST-2084) werden für HDR mindestens 10 Bits pro Abtastwert vorgeschrieben. Diese Bittiefe entspricht in etwa einer Milliarde Farbtöne, denn das Licht ist das Geheimnis von Detailgenauigkeit und brillanter Farbdarstellung. Insofern wird hier auch von der Farbtiefe bzw. Deep Color gesprochen. Mit den neuen Nanokristall-Technologien (z.B. OLED, Quantum Dots ) wurde die Grundlage geschaffen, die Farbtiefe auf 10 Bit oder gar 12 Bit zu erhöhen und den Dynamikbereich entsprechend auszuweiten. Moderne Displays werden nicht mehr flächendeckend, sondern je nach Bildinformation heller und dunkler (also dynamisch) bestrahlt oder die Bildpunkte leuchten individuell von selbst. Erst so kann der Kontrast erhöht, Weiß heller und Schwarz dunkler dargestellt werden, als es bisher möglich war. Die Steuerung von Farbton und Helligkeit erfolgt bei HDR also nicht mehr ausschließlich statisch, sondern in Abhängigkeit vom Bildinhalt. In der Gerätepraxis werden so Werte zwischen 0,01 und 4.000 cd/qm erzielt, was einem Dynamikumfang von 400.000:1 entspricht.

Mit HDR ist es somit möglich, die in der Natur vorkommenden Helligkeiten und Farben viel besser zu erfassen und entsprechend darzustellen. Über- oder Unterbelichtungen sind damit so gut wie ausgeschlossen. Deshalb können mit der HDR-Technologie und der entsprechenden Farbtiefe nunmehr Bilder und Videos erzeugt und wiedergegeben werden, die noch farbgewaltiger und detailreicher als mit 4K/UHD sind und darüber hinaus auch noch dem natürlichen Vorbild zum Verwechseln ähnlich sehen.

4. Adaption nach menschlichem Vorbild

Mithilfe des softwaregestützten HDR-Verfahrens wird es zukünftig also auch in der Fernsehtechnik möglich sein, mit dem Filmmaterial gezielt Informationen (Metadaten) zu übertragen, die im Display die Helligkeit dynamisch steuern. Somit können automatisch Bildverbesserungen insbesondere bei extremen Hell-Dunkel-Bereichen vorgenommen werden. Einfach ausgedrückt funktioniert HDR ähnlich wie die menschliche Wahrnehmung - speziell wie die Adaption im menschlichen Auge. Ob nun in tiefschwarzer Nacht oder im Licht eines 1000-Watt-Halogenstrahlers: unsere Augen können sich grundsätzlich an schier unzählige Lichtintensitäten anpassen. Differenzen in den Lichtverhältnissen kompensiert die Pupille durch Verengung oder Erweiterung (Hell-Dunkel-Adaption/Pupillenlichtreflex) sowie mit Veränderung in der Sensitivität der Rezeptoren.

Diese retinale Adaption hat die Natur dafür vorgesehen, dass wir unsere Wahrnehmung an stark unterschiedliche Umgebungshelligkeiten (Leuchtdichten) anpassen können. So schafft es unser Auge, sagenhafte 10.000.000.000.000 (1012) verschiedene Reizstärken zu differenzieren, um somit die Orientierung bei Nacht zu gewährleisten. Auch bei direkter Sonneneinstrahlung können wir beispielsweise Spuren im Schnee erkennen, was auf die einzigartige Wechselwirkung zwischen Auge und Gehirn zurückzuführen ist. Jetzt schafft auch die Technik zumindest ansatzweise, was bisher nur der Natur vorbehalten war. Mit der 4K-Auflösung waren wir schon ziemlich dicht an der Realität, mit HDR wird der Unterschied zwischen einem künstlichen Display und dem Original in der Natur immer geringer.

5. Nicht alle Geräte der 2016er Serie sind tatsächlich HDR-fähig

Was zu Beginn des digitalen TV-Zeitalters noch als technische Herausforderung galt, ist also heute zumindest in einigen Geräten möglich. Erste HDR-taugliche TV-Modelle kamen Ende 2015/Anfang 2016 auf den Markt. Wer besonderen Wert auf extrascharfe Bilder und einzigartige Kontraste legt, der sollte auf die jeweiligen Spezifikationen und Mindestanforderungen achten, die unter anderem von der UHD Alliance mit ihrem Label „Ultra HD Premium“ festgelegt bzw. zertifiziert werden. Hierzu zählt insbesondere die Spitzenhelligkeit von mindestens 1.000 Nits, welche die Grundvoraussetzung für HDR darstellt. Wer auf Nummer sicher beim Kauf gehen möchte, der sollte sich generell an dem Label der UHD Alliance orientieren, mit dem nicht nur HDR-fähige TV-Geräte, sondern auch Player und sogar Blu-ray-Disks ausgestattet sind.

6. Doch wo Licht ist, ist auch Schatten!

Kaum jemand wird sich an die Umstellung vom Schwarz-Weiß- zum Farb-Fernsehen erinnern. Doch grundsätzlich gab es damals ähnliche Probleme wie heute. Der Grund war und ist die Kompatibilität der verschiedenen Systeme. Gerade im Broadcast- bzw. Fernsehbetrieb sind die Herausforderungen an die Entwickler gigantisch, aber auch für HDR aus der „Konserve“ (Blu-ray-Disk) oder gar im Online-Stream sind noch längst nicht alle Voraussetzungen geschaffen. Das liegt zum einen daran, dass es zumindest für eine absehbare Zeit sowohl SDR- als auch HDR-Angebote geben muss, weil natürlich nicht jeder ab sofort ein HDR-fähiges Gerät zu Hause stehen hat. Wir sind gerade erst dabei, die letzten Röhrenfernseher auf den Müll zu werfen und das analoge Signal restlos abzuschalten. Deshalb muss bei der Entwicklung einer Übertragungstechnik insbesondere die Kompatibilität berücksichtigt werden. Ähnlich wie bei der Auflösung (Full HD/Ultra HD) müssen die technischen Standards also geräteunabhängig praktikabel sein, da in den nächsten Jahren SDR und HDR parallel laufen müssen.

Insofern wurden und werden verschiedene HDR-Standards entwickelt. Der wohl aktuell meist verbreitete ist HDR-10, welcher überwiegend in den 2016er TV-Modellen vorkommt und auch für 4K-Blu-ray vorgesehen ist. Jedoch verspricht das technisch ausgefeiltere Format „Dolby Vision“ bereits jetzt eine noch bessere Qualität, deshalb wird sich diese Technik in nächster Zeit wohl weiter am Markt durchsetzen. Neben einer dritten Variante von Technicolor & Philips, die vorrangig für Streaming und Blu-ray entwickelt werden soll, tüfteln auch Sendeanstalten (z.B. BBC) an eigenen Verfahren, die sich allerdings mehr mit der Fernsehübertragung befassen.

Grundsätzlich unterscheiden sich die einzelnen HDR-Standards im Mastering-Prozess und der Übertragungsform der Metadaten. So liegt bei HDR-10 die Farbtiefe bei 10-Bit, Dolby Vision arbeitet hingegen mit 12 Bit, also einem weitaus breiterem Helligkeitsumfang, was für höhere Bildqualität sorgt. Zudem können die Bildinhalte hier besser an das Display angepasst werden, da die Informationen pro Bild übertragen werden. Insofern greifen die ersten TV-Hersteller (z.B. LG, Sony) nach „Dolby Vision“, mit deren Unterstützung die HDR-Umsetzung noch besser gelingen soll. Ob dieser Standard bei Blu-ray-Playern ebenfalls übernommen wird, ist derzeit noch nicht bekannt.

Das Ziel aller Entwicklungen ist, für möglichst viele herkömmliche und zukünftige Displays mit ganz unterschiedlichen Systemvoraussetzungen (z.B. Spitzenhelligkeit, Schwarzwert) ein optimales Ergebnis zu schaffen, das sowohl SDR als auch HDR beinhaltet. Im Gegensatz zur Auflösung, bei der es lediglich um die Anzahl der Bildpunkte geht, ist HDR weitaus komplexer. Deshalb hilft hier kein schlichtes Upgrade.

7. Das Problem liegt zwischen Aufnahme und Wiedergabe

Wie bereits erwähnt, stammt HDR eigentlich aus der digitalen Fotografie bzw. Bildbearbeitung. Um dunkle und helle Szenen gleichzeitig so detailreich wie möglich zu gestalten, behilft man sich hier mit einem kleinen Trick. Dieselbe Szene wird mit unterschiedlichen Belichtungen mehrfach aufgenommen und im Anschluss mithilfe einer passenden Software zusammengesetzt. Damit solche Aufnahmen mit einem großen Dynamikumfang auch kompatibel sind und dementsprechend auf Geräten mit einem geringen Kontrast angezeigt werden können, kommt das sogenannte Tonemapping zum Einsatz, das noch im Detail erläutert wird.

Beim Film wird seit einiger Zeit mit einem sehr großen Szenenkontrastumfang und entsprechenden Kompressionsverfahren („Color Grading“) gearbeitet, weshalb die Dynamik zwischen Hell und Dunkel hier bereits gegeben ist. Hochwertige Kameras können heute im Umfang von bis zu 14 Blendenstufen aufnehmen, denn sie verfügen über präzise Sensoren, die Licht in ein elektrisches Signal umwandeln. Diese Umwandlung von Photonen zu Elektronen bis hin zum Videosignal wird über eine sogenannte Opto-Electronic-Transfer-Funktion (OETF) definiert. Ursprünglich wurde diese Funktion (auch als Gammavorentzerrung bekannt) dazu benutzt, in Röhrenmonitoren die nicht-lineare Electronic-Opto-Transfer-Funktion (EOTF) zu kompensieren. Diese EOTF wurde seinerzeit in der ITU-Empfehlung BT.1886 standardisiert. Da diese Gammavorentzerrung als Potenzfunktion mit dem Exponenten 2,4 dem menschlichen Kontrastempfinden sehr ähnlich ist, wurde sie sowohl in der HDTV-Norm BT.709 (mit 8 Bit oder 10 Bit) als auch in der BT.2020 für UHDTV-Signale (mit 10 Bit oder 12 Bit) beibehalten. Der einzige Unterschied liegt hier also in der Quantisierung.

Moderne Kameras verwenden also überwiegend eine logarithmische Kurve (OETF), während Displays auf die herkömmliche Gammavorentzerrung (EOTF) zurückgreifen. Beide Standards arbeiten unabhängig voneinander und sind längst nicht in jedem Gerät gleich. Denn die verschiedenen Hersteller nutzen speziell optimierte log-Funktionen für den jeweiligen Sensor, damit die Kameras mit einem möglichst hohen Szenenkontrastumfang und möglichst geringem Datenvolumen aufnehmen. Die OETF (Aufnahme) ist also variabel und darüber hinaus nicht spezifiziert. Und genau hier liegt das Problem. Denn für eine perfekte Rekonstruktion (also die Umwandlung eines elektrischen Signals in ein optisches Signal) muss auf der Wiedergabeseite (EOTF) bekannt sein, mit welcher Wiedergabekennlinie gearbeitet werden muss. Ist dies nicht bekannt, wird es schwer bis unmöglich, den gesamten Dynamikumfang der Aufnahme bei der Wiedergabe zu erhalten.

So sind heute auch Fernsehkameras sehr wohl in der Lage, mit einem größeren Dynamikumfang aufzuzeichnen. Jedoch wurde dieses Feature bisher vernachlässigt, da es keine geeigneten Verarbeitungsmöglichkeiten in der Produktions- und Sendekette gab. TV-Signale werden live übertragen, eine nachträgliche manuelle Bearbeitung wie beim Film ist also beim Broadcast naturgemäß ausgeschlossen. Für die direkte Übertragung von HDR-Inhalten bedarf es insofern automatischer Verfahren, die eine hersteller- sowie systemunabhängige Signalverarbeitung zulassen und eine qualitativ hochwertige Wiedergabe sowohl in HDR als auch in SDR realisieren. Der simpelste Denkansatz hierfür war und ist die Weiterentwicklung des Tonemappings.

8. Tonemapping

Das Ziel der HDR-Entwicklung ist also nicht nur, die technischen Voraussetzungen für HDR sowohl bei der Aufnahme (Kamera) als auch bei der Wiedergabe (Display/Fernseher) zu schaffen. Die Schwierigkeit liegt in der Kompatibilität zwischen Sender und Empfänger und der Abwärtskompatibiliät der einzelnen Standards (HDR – SDR). Insofern bietet sich die sogenannte Hybrid-Log-Gamma-Funktion (HLG) an, die dafür sorgt, dass der Dynamikumfang abwärtskompatibel komprimiert wird, was allgemeinhin als Tonemapping bekannt ist. Natürlich kann dieses Verfahren aus der Digitalfotografie nicht eins-zu-eins in den Videobereich übernommen werden. Denn anders als bei einzelnen Bildern müssen Filmsequenzen über eine temporale Homogenität und eine Echtzeitfähigkeit verfügen und darüber hinaus gilt es, Artefakte zu vermeiden. In der Weiterentwicklung des Tonemappings gibt es nunmehr zwei Varianten. Einerseits das globale Tonemapping, bei der auf Basis einer durchschnittlichen und maximalen Leuchtdichte jedes Pixel mit derselben Übertragungskurve gewichtet wird. Der Vorteil liegt in der niedrigen Rechenintensität, der Möglichkeit, das Ursprungssignal zurückzugewinnen (inverses Tonemapping) und der geringen Artefaktebildung. Wenn es jedoch darum geht, einen möglichst großen Szenenkontrastumfang darzustellen, bietet das lokale Tonemapping bessere Chancen, einen höheren Kontrast zu bewahren. Denn mit einer höheren Datenkompression kann hier auch die Umgebung eines jeden Pixels berücksichtigt werden. Wenn man bedenkt, dass ein UHD/4K-Bild über 8 Millionen Pixel hat und mit der BT.2020 zukünftig bis zu 120 Bilder pro Sekunde (120 Hz) übertragen werden sollen, kann man sich die unglaubliche Rechenleistung und das entsprechende Datenvolumen zumindest ansatzweise vorstellen. Insofern stellt sich in diesem Zusammenhang die Frage nach der besten Übertragungsmethode, wie also die nötigen Informationen am besten und schnellsten vom Sender zum Empfänger gelangen und welche Codierung/Decodierung sinnvoll ist.

9. HDR-Übertragungsmethoden

Ähnlich wie bei 2D/3D oder auch SD/HD seinerzeit und dem erweiterten Farbraum zukünftig, besteht auch hier die Notwendigkeit, sowohl SDR- als auch HDR-Inhalte gleichzeitig zu übertragen sowie zu codieren. Dafür gibt es derzeit drei verschiedene Varianten.

Einfacher Single-Layer: Hier wird die Szene über einen einzigen Datenstrom transportiert und mithilfe einer Transformationskurve (Hybrid-Log-Gamma-Kurve: HLG) so codiert, dass die Videoinhalte auf jedem handelsüblichen Display (SDR und HDR) wiedergegeben werden können. Metadaten sind hierfür nicht erforderlich, dafür ist der Dynamikumfang begrenzt.

Doppelter Single-Layer: Mit einer Punkt-zu-Punkt-Verbindung wird die Szene in zwei voneinander getrennten Datenströmen übertragen, wobei der eine Stream die SDR-Inhalte und der andere die HDR-Inhalte enthält. Je nach Display-Typ kann so das jeweils passende Signal abgerufen werden.

Dual-Layer: Auch hier werden zwei unterschiedliche Streams (SDR: Basis-Layer/HDR: Enhancement-Layer) genutzt, die jedoch parallel über nur einen Datenstrom übertragen werden. Die zusätzlich mitgelieferten Metadaten sorgen dann dafür, dass beide Signale im jeweiligen Endgerät entsprechend getrennt bzw. einzeln abgerufen werden können.

10. Metadaten

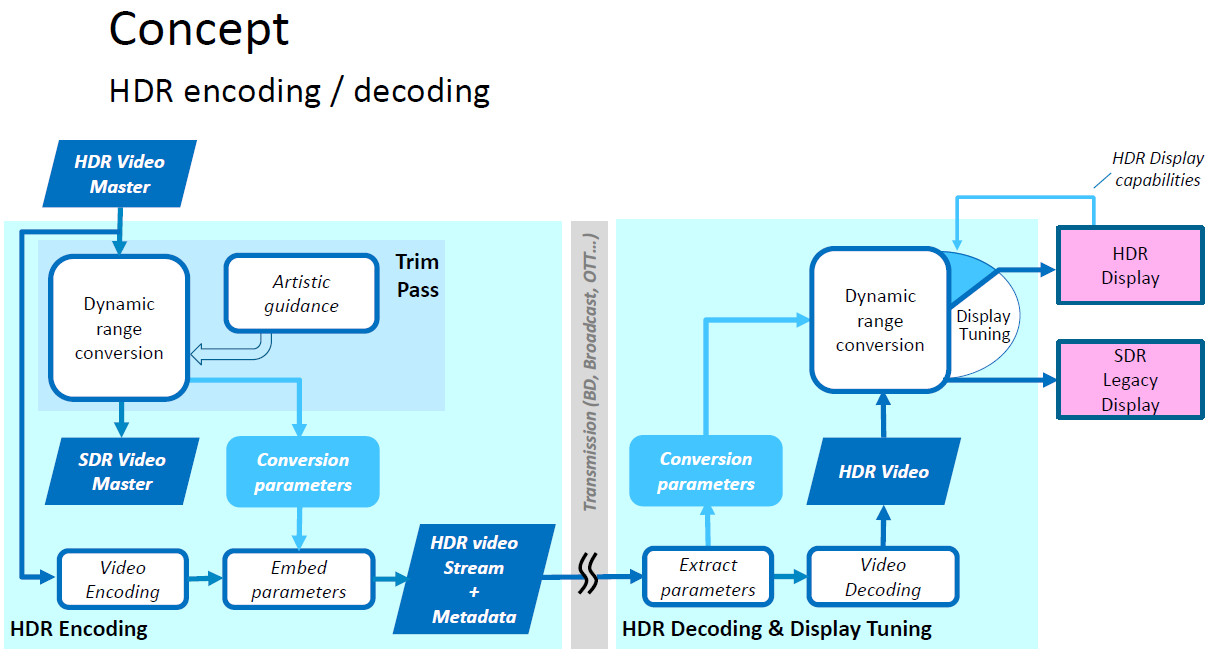

Ein großer Schritt in Richtung Kompatibilität setzen Metadaten, die dem Datenstrom hinzugefügt werden. Wesentliche Grundvoraussetzung ist hier natürlich ein einheitlicher Standard, sodass diese auch auf allen gängigen Signalübertragungswegen (z.B. SDI, IPTV, OTT) Verwendung finden können. Eine besondere Herausforderung ist auch hier die Übertragung in Echtzeit, wie beim Broadcast/Fernsehen, da die Informationen synchron und verlustfrei weitergegeben werden und die Verzögerung bei der Signalverarbeitung so gering wie möglich sein müssen. Insofern wird heute von den Entwicklern für Fernsehübertragungen der einfache Single-Layer-Betrieb präferiert. Bei Nicht-Echtzeitanwendungen kann sich quasi Zeit gelassen werden und die statischen Metadaten auch noch während der Nachbearbeitung hinzugefügt bzw. abgespeichert werden. Entscheidend sind hier die Informationen über die Erstellung des Videomaterials während des Mastering-Prozesses, um die Wiedergabe möglichst originalgetreu zu realisieren. Damit Aufnahme und Wiedergabe sozusagen dieselbe Sprache sprechen, wurden im SMPT-Standard ST-2086 konkrete Werte für das Mastering-Display festgelegt. Dazu gehören die X/Y-Koordinaten der drei Display-Primärvalenzen sowie des Weißpunkts und darüber hinaus die maximale/minimale Leuchtdichte. Diese werden in den Metadaten beschrieben, damit die Wiedergabe das Mastering nachvollziehen kann. Bei 4K-Blu-ray/HDR ist es möglich, weitere Informationen (Metadaten) hinzuzufügen, die sich im RGB-Kontext auf den maximalen Wert in einer Szene (Maximum Content Light Level: MaxCLL) und den durchschnittlichen Wert (Maximum Frame-Average Light Level: MaxFALL) von Szene zu Szene beziehen.

Diese dynamischen Metadaten dienen vorrangig der Kompatibilität zwischen Mastering-Display und Bildschirmen mit geringem Dynamikumfang. Die Basisparameter hierfür sind in der SMPTE ST-2094-1 und ST-2094-2 spezifiziert und umfassen grundsätzlich vier unterschiedliche Anwendungen:

Transformation: Abhängig vom Eingangsbild wird hier aus dem Ausgangsmaterial ein Bild generiert und kann manuell verändert werden (Tonemapping).

Color-Grading: Hier werden bestimmte Parameter festgelegt, wie und wo (manuell oder automatisch) Helligkeits- und Farbveränderungen vorgenommen werden sollen, welche dann in den Metadaten übertragen werden.

Differenzierung: Aus dem HDR-Inhalt und den zusätzlich gelieferten Metadaten wird ein SDR-Bild gewonnen.

Spezifikation: Auf Basis der maximalen Leuchtdichte von Mastering- und Wiedergabedisplay werden mithilfe von Tonemapping-Algorithmen spezifische Parameter berechnet, um das HDR-Material bei der Wiedergabe möglichst originalgetreu darzustellen.

11. HDR-Systeme und ihre verschiedenen Ansätze

Während perspektivisch BBC/NNK insbesondere vor dem Hintergrund der Live-Übertragung im Broadcast-Bereich die einfache Single-Layer-Methode nutzen wollen, bevorzugen Dolby, Philips und Technicolor komplexere Methoden. Hierbei stützen sich die Entwicklungsansätze bei Dolby Vision auf die Übertragung der Metadaten im Enhancement-Layer. Technische Basis hierfür ist die sogenannte Preceptual-Quantizer-Kurve (PQ) gemäß SMPTE ST-2084. Beim Mastering des EDR-Materials (Extended Dymanic Range) werden darüber hinaus Metadaten erzeugt, die weitere Informationen zur Darstellung des Bildmaterials enthalten. Natürlich gibt es das alles nicht umsonst. Die Datenrate des Enhancement-Layers steigt proportional zum Umfang der Metadaten und liegt etwa 25 Prozent über der des Basis-Layers. Dolby Vision setzt bei seinem DolbyVision-System auf die automatische Konvertierung des oben beschriebenen lokalen Verfahrens (Content Mapping Unit: CMU), bei dem aus der HDR-Version das SDR-Material generiert wird. Dazu werden aus dem HDR-Grading die entsprechenden Einstellungen abgeleitet und bei der Reproduktion die nötigen Informationen für das SDR-Grading geliefert.

Philips nutzt für die Übertragung einen Basis-Layer zuzüglich Metadaten, aus denen die jeweilige Version (SDR/HDR) im Wiedergabegerät reproduziert werden kann. Sollte es nur eine HDR-Version im Original geben, wird das SDR-Bild mithilfe des automatischen Tonemappings inklusive manueller Bildoptimierung erzeugt. Bei Technicolor wird die HDR-Version vorverarbeitet, sodass jedes HDR-Bild quasi aus einem SDR-Bild und den dazugehören Modulations-Metadaten besteht. So kann über das SDR-Signal beispielsweise via HEVC/Main 10 codiert, übertragen und in einem SDR-Display entsprechend wiedergegeben werden. Genau wie bei Philips werden die zusätzlichen dynamischen Metadaten für die Modulation in HDR in sogenannten SEI-Paketen (Supplemental Enhancement Information) an ein entsprechendes Wiedergabegerät weitergeleitet und dort zu einem HDR-Bild reproduziert. Hier kommt ebenfalls die inverse Funktion des Vorverarbeitungsprozesses zum Einsatz. Da sich beide Systeme im Over-The-Top-Content (OTT) sehr ähnlich sind, wurde sich hier darauf geeinigt, gemeinsam ein einheitliches Verfahren zu entwickeln. Technicolor verkündete dies in einer Pressemitteilung vom 4. Januar 2016.

12. HDR erst vollkommen mit entsprechend produziertem Videomaterial

Wer nach passendem Videomaterial Ausschau hält, das in HDR produziert wurde, muss mit der Lupe suchen. Bei TV-Sendern ist HDR vor allem wegen der mangelnden Kompatibilität in der Signalverarbeitung noch reine Zukunftsmusik – ähnlich wie übrigens auch der erweiterte Farbraum gemäß BT.2020. Deshalb haben momentan ausschließlich die Streamingdienstleister in punkto Bildtiefe und Farbbrillanz die Nase vorn. Sowohl Amazon bietet erste Video-Titel mit einem HDR-Etikett an, aber auch Netflix hält sein Versprechen und produziert zunehmend Filme und Serien sowohl ultrahochauflösend als auch mit höherem Dynamikumfang. Laut Pressemeldung vom 19. April 2016 wird Netflix bis Jahresende UHD-Videomaterial in HDR-Qualität mit einer Länge von insgesamt 250 Stunden zur Verfügung stellen.

Wenn auch schleppend so gibt es mittlerweile doch die ersten Blu-ray-Disks in Ultra HD plus HDR. Natürlich macht das Ganze nur richtig Spaß, wenn Sie die entsprechenden HDR-tauglichen Geräte besitzen. Alles in allem sollten Sie beim BD-Kauf ebenfalls auf das Premium-Zertifikat der UHD Allicance achten. Ähnlich wie bei 3D gibt es hier mehrere Disks in unterschiedlichen Formaten in einem Cover.

13. HDR nur mit dem richtigen Kabel

Selbst wenn Ihnen echte HDR-Inhalte zur Verfügung stehen, die Sie nun auf Ihren HDR-tauglichen Fernseher streamen oder über Ihren HDR-tauglichen Blu-ray-Player abspielen möchten, bleibt noch die Frage der richtigen Leitung. Das Datenvolumen von 4K/Ultra HD ist schon gewaltig. Nun müssen im Datenstrom auch noch zusätzliche Metadaten für die Leuchtdichte an das Display weitergegeben werden. Mit HDMI-Kabeln der älteren Generation kommen Sie hier deshalb nicht weiter. Achten Sie auf den aktuellen HDMI-Standard 2.0a und verwenden Sie nicht zu lange Kabel.

Kurzum: HDR steckt noch längst nicht in jedem TV. HDR ist nicht gleichzusetzen mit 4K/UHD. HDR bleibt vorerst in den meisten Wohnzimmern reine Zukunftsmusik. Hollywood wird auch in nächster Zeit nur sehr spärlich in HDR produzieren. Eine TV-Übertragung in HDR-Qualität ist absolute Utopie. Und solange das so bleibt, bietet BUROSCH Referenz-/Testbilder gemäß der aktuellen Videonorm BT.709 an. Lassen Sie sich also nicht verwirren, Rom wurde schließlich auch nicht an einem Tag erbaut.

© BUROSCH, 2016

Weitere Artikel zum Thema:

BT.2020: Der lange Weg zum erweiterten Farbraum

Jetzt kommt Licht ins Dunkel: UHD Alliance vergibt ab sofort einheitliches Logo "Ultra HD Premium"

Was bringt OLED im Vergleich zu LED/LCD & Co.?

Quantum Dots - mehr als nur Punkte