Der Begriff Digitalisierung bedeutet im Grunde nichts anderes, als dass aus dem analogen Videosignal das digitale gewonnen wird. Dabei handelt es sich um drei aufeinanderfolgende Vorgänge, die in der Summe als Digitalisierung bezeichnet werden: + Diskretisierung + Quantisierung + Codierung/Decodierung.

Diskretisierung

Das Analogsignal wird sowohl vertikal als auch horizontal in Zeilen und Bilder unterteilt. Die Informationen liegen also zeitkontinuierlich und wertkontinuierlich vor und müssen im Rahmen der Digitalisierung diskretisiert werden. Damit ist gemeint, dass aus einer kontinuierlichen Daten- oder Informationsmenge (Analogsignal) eine diskrete Teilmenge (Digitalsignal) gewonnen wird. Denn in der Digitaltechnik erfolgt die Übertragung der Signalwerte nicht kontinuierlich, sondern quantisiert und zu klar definierten Zeitpunkten.

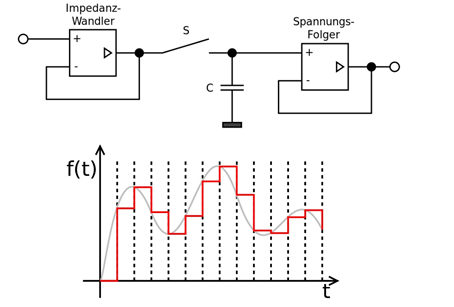

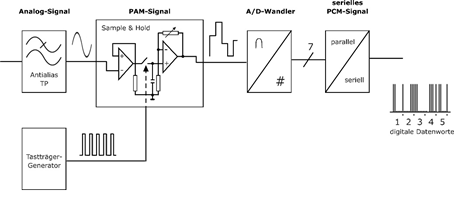

Diskretisierung bedeutet im Kontext der Digitalisierung des Fernsehsignals die Abtastung beziehungsweise Modulation. Diese zeitliche Diskretisierung erfolgt in regelmäßigen Abständen, in denen dem zu wandelnden Signal Proben (sogenannte Samples) entnommen werden, die bis zur nächsten Entnahme gespeichert werden. Dieser Vorgang wird auch Hold genannt. Eine solche Sample-Hold-Schaltung (Abtast-Halte-Schaltung) wird durch die Aufladung eines Kondensators realisiert.

Die Abtastrate oder -frequenz gibt an, wie viele Abtastwerte pro Zeiteinheit vorliegen. Je höher diese Abtastfrequenz (Samplingrate) ist, desto störfreier ist das Signal. Allerdings müssen auch entsprechend viele Daten übertragen werden. Mit zunehmender Qualität steigt somit die Datenrate.

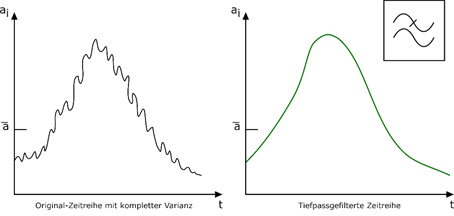

Nach dem sogenannten Abtasttheorem sollte die Samplingrate nicht niedriger aber auch nur maximal doppelt so hoch sein wie die höchste auftretende Signalfrequenz des Originals. Parallel muss darauf geachtet werden, dass oberhalb dieser Signalfrequenz keine Spektralanteile im Signal auftreten (Störfrequenzen). Um dies zu vermeiden, ist vor der A/D-Umsetzung eine Tiefpassfilterung erforderlich. Mithilfe dieser Tiefpassfilterung, einem spektralen statistischen Analyseverfahren zur numerischen Zeitreihenfilterung, werden aus einer Zeitreihe nicht nur die tiefen Frequenzen herausgefiltert, sondern auch hohe Frequenzen unterdrückt, die so im Original nicht vorkommen (Abbildung 126).

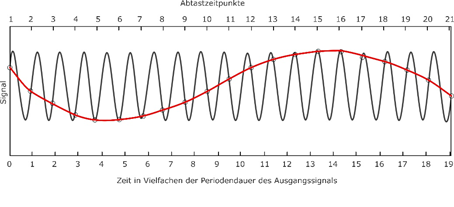

Ohne Tiefpassfilterung können oberhalb des Originalsignals Störsignale auftreten, die das Abtastsignal überlagern. Das heißt, im Abtastsignal können Frequenzanteile enthalten sein, die höher sind als die sogenannte Nyquist-Frequenz (halbe Abtastfrequenz). Denn aus der Differenz zwischen Original- und Abtastfrequenz bilden sich sogenannte Aliaseffekte, die sich als Fehler in der Bilddarstellung äußern. Deshalb sollte beim Abtasten digitaler Signale sowohl das Abtasttheorem Beachtung finden, als auch Störsignale vermieden werden, die das Originalsignal (Alias) überlagern.

Abbildung 127 zeigt das Missverhältnis zwischen Abtastsignal (rot) und kontinuierlichem Originalsignal (grau), wie es bei einer Zeitdiskretisierung mit falscher Abtastfrequenz entsteht. Mithilfe sogenannter A/D-Wandler werden die originalen analogen Videosignale in digitale Datenströme gewandelt beziehungsweise rekonstruiert, wobei die Analog-Digital-Wandlung für das Luminanz-Signal (Y) und die Farbdifferenz-Signale (B-Y) und (R-Y) getrennt erfolgt. Diese Wandlung bezieht sich auf die Übertragung von unendlich vielen Analogwerten in eine begrenzte Menge zählbarer Quantitäten, die als Binärcodes bezeichnet werden. Auch bei wiederholter Wandlung der Signale (A/D- bzw. D/A-Umsetzung) kann es zu den oben genannten Aliaseffekten kommen, da eine mehrfache Filterung mit der gleichen Grenzfrequenz zu einer Verringerung der Gesamt-Grenzfrequenz führen kann.

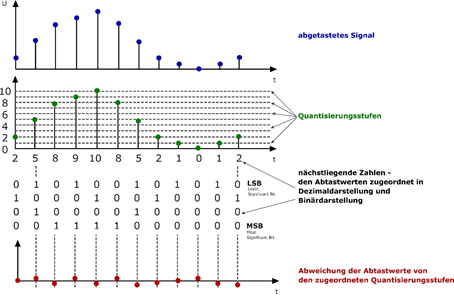

Zum Abschluss des ersten Schritts der Digitalisierung (Abtastung) liegt ein sogenanntes PAM-Signal (puls-amplitudenmoduliert) vor, welches allerdings noch analog ist. Ausgehend von diesem PAM-Signal wird die Maximalamplitude des Sample-Hold-Signals auf die Wandler-Kennlinie eines A/D-Wandlers angepasst beziehungsweise in binäre Datenworte gewandelt. Die jeweiligen positiven wie negativen Signalspannungen oder auch Amplitudenbereiche werden in definierte Spannungsstufen eingeteilt. Dieses Verfahren wird Quantisierung genannt.

Quantisierung

Mit einer Band- beziehungsweise Kanalbreite von 6 MHz können im digitalen Fernsehen Video-, Audio-, Hilfs- und Steuerdaten übertragen werden. Neben den aus der Analogtechnik bekannten Übertragungswegen (Satellit, Kabel und Antenne) kommt beim digitalen Standard die Übertragung via IP-Signal (Internet) hinzu. Auf Basis des ursprünglichen MHP-Standards (Multimedia Home Plattform) können die verschiedenen Übertragungswege kombiniert und sogenannte Hybrid-Endgeräte angeboten werden. Näheres hierzu findet sich im Kapitel „Praxis der modernen Fernsehtechnik“.

Die Datenraten der einzelnen Übertragungswege sind dabei sehr unterschiedlich. Allen gemeinsam ist die konsequente Nutzung verschiedener Verfahren zur Datenreduktion, die eine Übertragung hoher Datenraten auf geringen Bandbreiten zulassen. Bei vorhandener Bandbreite können somit mehrere Fernsehkanäle gleichzeitig übertragen werden, was beim analogen Fernsehsignal nicht möglich war. Während des Prozesses der Digitalisierung werden die Abtastwerte also nicht nur moduliert (zeitlich diskretisiert), sondern auch quantisiert.

Bei der (Amplituden-)Quantisierung gilt: je mehr Quantisierungsstufen, desto besser die Signalqualität (Videoauflösung). Fehler treten dennoch auf, die sich in einem Rauschen äußern können. Tolerierbare Fehler werden über den sogenannten Signal-Rauschabstand (S/N) bestimmt, der im Videobereich bei < 45 dB und im Audiobereich bei > 90 dB liegt.

Insofern kann im Rahmen der Quantisierung (Auflösung) im Videobereich mit weniger Stufen (256/8 Bit) als beim Audiosignal (65000/16 Bit) gearbeitet werden, da der Gesichtssinn in der Regel weniger ausgeprägt ist als der Gehörsinn und sogenannte Quantisierungsgeräusche damit im tolerierbaren Bereich liegen. Durch die unterschiedliche Wahrnehmung und entsprechenden Toleranzgrenzen sind die Werte sowie Formeln zur Bestimmung des jeweiligen Signal-Rauschabstandes bei Audio- und Videosignalen unterschiedlich. Auf die Darstellung einer detaillierten Berechnung der Quantisierungsrauschleistung, Quantisierungsfehlerspannung und Signalleistung wird im Rahmen dieses Praxishandbuches verzichtet.

Bei der Signalverarbeitung kann es gerade bei höheren Auflösungen zu Rundungsfehlern kommen, die zwangsläufig entstehen, wenn unendlich viele Werte auf eine endliche Zahl reduziert werden (Quantisierungsfehler). Diese Quantisierungsfehler können insbesondere bei hohen Signalpegeln auftreten und werden dann im Videobereich als stufige Grauwerte oder im Audiobereich als unangenehmes Rauschen wahrgenommen. Deshalb werden diese Fehler auch als Quantisierungsrauschen bezeichnet, das mithilfe sogenannter Dither (zugesetzte unregelmäßige Signale) verdeckt wird.

In der Videotechnik werden verschiedene Verfahren zur Quantisierung (A/D-Umsetzung) verwendet. Die schnellste Variante ist der sogenannte Parallelumsetzer, bei dem ein gleichzeitiger (paralleler) Vergleich der umzuwandelnden Spannung mit allen Quantisierungsstufen erfolgt. Hier werden die Spannungswerte der Stufen aus einem Spannungsteiler gewonnen, wobei bereits nach dem ersten Vergleichsschritt ein quantisiertes Signal vorliegt. Da bei einer Auflösung mit 8 Bit gleichzeitig 256 Vergleichswerte vorliegen müssen, ist dieses Verfahren in technischer Hinsicht sehr anspruchsvoll.

Eine einfachere Variante ist die Wägewandlung, bei der die analogen und digitalen Datenwerte in mehreren Schritten gewandelt und verglichen werden, bis sich der Digitalwert dem analogen bestmöglich angenähert hat. Im Gegensatz zum Abwägeprinzip dieser Variante gibt es ein weiteres Quantisierungsverfahren, das im Audiobereich angewandt wird. Beim sogenannten Zählwandler läuft vom Minimum bis zum Maximum des zu wandelnden Signals eine sogenannte Sägezahnspannung (Abbildung 38). Beim Anstieg läuft quasi eine Stoppuhr (Digitalzähler), bis die Sägezahnspannung den Wert erreicht hat, der gewandelt werden soll.

Die Wandlung von analogen und digitalen Signalen kann auch umgekehrt werden. Bei der sogenannten Rückwandlung durch D/A-Umsetzer kann allerdings nicht das Originalsignal wieder hergestellt werden, da die Quantisierungsfehler erhalten bleiben. Auch zur Rekonstruktion werden eine Sample-Hold-Schaltung sowie Tiefpassfilter verwendet, wobei man in diesem Zusammenhang von Rekonstruktionsfiltern spricht. Abbildung 130 zeigt den gesamten Quantisierungsprozess in beiden Richtungen als Blockschaltbild.

Codieren/Decodieren

Im Zeitalter der hochauflösenden Videoformate werden deren Datenmengen immer größer, die entsprechend komprimiert übertragen werden müssen. Dazu ist es notwendig, mithilfe eines Algorithmus‘ aus den Daten des Originals (der Quelle) einen komprimierten Datenstrom zu erzeugen. Dieser kann dann entsprechend übertragen oder gespeichert werden. Dieses zusammengehörende Algorithmenpaar zur Codierung beziehungsweise Decodierung digitaler Videosignale nennt man Videocodec.

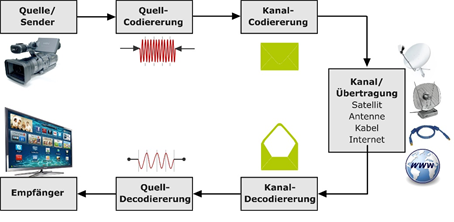

Bei der Codierung werden Informationen von der Quelle abgeschickt und im Quellcodierer komprimiert. Dabei muss der Originaldatenstrom so komprimiert werden, dass er auch nach der Codierung noch eindeutig rekonstruierbar ist. Dieses Verfahren wird entsprechend als Quellcodierung bezeichnet. Ein Beispiel für einen Quellcode ist der sogenannte Huffman-Code. In einem zweiten Schritt wird der möglichst gut decodierbare Datenstrom an den jeweiligen Übertragungskanal angepasst (Kanalcodierung). Kanalcodes werden auch als Blockcodes bezeichnet (z.B. Hamming- oder Golay-Code). Bei der Kanalcodierung spielen insbesondere Fehlererkennungs- und Fehlerkorrekturmöglichkeiten eine wesentliche Rolle. Denn in der Regel kann bei sehr hohen Datenmengen kaum verlustfrei komprimiert werden.

Insofern werden Videocodecs generell in zwei Kategorien unterteilt, die sich jeweils in ihrer Anwendung und den daraus resultierenden Ansprüchen begründen. Für hohe Qualität bei ebenfalls hoher Übertragungsrate, wie sie bei DVB und DVD üblich sind, stehen beispielsweise die Standards MPEG-2, MPEG-4-AVC/H.264 oder aktuell in Deutschland als High Efficiency Video Coding (HEVC) H.265. Soll eine möglichst niedrige Datenmenge übertragen und damit sowohl die Rechenleistung als auch der Energieverbrauch gering gehalten werden, kommen dagegen Standards wie H.263 oder VP8 zum Einsatz. Dies ist insbesondere bei mobilen Endgeräten (z.B. Smartphones) der Fall.

Beim digitalen Fernsehen wird zuerst das Programm selbst codiert. Dafür wurde bisher der MPEG-2-Standard verwendet, moderne Verfahren wie DVB-S2 sowie UHD verwenden MPEG-4. Im Anschluss erfolgt im Multiplexer eine Verschachtelung des Programms mit etwaigen Zusatzdiensten zu Datenpaketen. Innerhalb eines Paketes lassen sich mehrere Programme (Fernsehen oder Radio) zu einem Datenstrom kombinieren (Transportstrom), der wiederum mit dem Trägersignal moduliert wird. Abschließend wird das Signal verstärkt und zum Übertragungssender (Satellit, Kabel, Antenne) gelenkt.

Nach der Übertragung müssen die komprimierten Daten im Wiedergabegerät wieder decodiert beziehungsweise encodiert werden. Das Verfahren läuft also quasi rückwärts ab: im Kanaldecodierer werden die empfangenen Dateien rekonstruiert, im Quellcodierer entsprechend decodiert, wobei idealerweise das rekonstruierte Videosignal möglichst identisch ist mit dem Originalsignal.

Beim Codier- beziehungsweise Decodiervorgang ist vor allem ein synchroner Takt (gleiche Bitfolge) sowohl im Sender als auch im Empfänger nötig, damit im Wiedergabegerät auf derselben Grundlage die Daten rekonstruiert und decodiert werden können, wie sie zuvor im Sender quantisiert und codiert wurden. Die Takt- beziehungsweise Bitfolge lässt sich aus dem übertragenen Signal entnehmen, indem bei jedem Übergang von 0 auf 1 oder 1 auf 0 der abgelaufene Taktzyklus erkennbar ist. Um Fehler (Taktabweichungen) zu vermeiden, muss die Anzahl der Signalwechsel (0/1 oder 1/0) pro Bit, die gleichbedeutend mit der Modulationsrate ist, möglichst gering gehalten werden. Je höher die Modulationsrate, desto geringer die Effizienz der Codierung. Für die Codierung stehen mehrere Möglichkeiten zur Verfügung, wobei gilt: je fehlerfreier komprimiert werden soll, desto komplizierter ist der Codierungsalgorithmus.

RZ (Return to Zero)

Nach dem einfachen Prinzip 0/1 = aus/ein wird jedes 0-Bit mit einem sogenannten Low-Signal (niedrige Spannung) codiert und jedes 1-Bit mit einem High-Signal (hohe Spannung). Nach jedem High-Signal (1-Bit) wird das Bit auf Null (Low-Signal) zurückgesetzt.

NRZ (Non-Return to Zero)

Hier bleibt die Spannung gleich, das heißt, nach dem Wert 1 wird das Bit nicht auf Null zurückgesetzt. Die Grenzfrequenz ist hier niedriger als im RZ-Verfahren und erlaubt dadurch eine geringe Modulationsrate. Allerdings ist dieses Verfahren anfällig, da bei aufeinanderfolgenden gleichen Bits kein Signalübergang erfolgt (keine Null-Schaltung). Insofern ist die richtige Bitfolge nicht immer erkennbar und es kann zu Fehlern bei der Synchronisation kommen.

NRZI (Non-Return to Zero Inverted)

1-Bit wird hier nicht als High-Signal, sondern direkt als Signalwechsel dargestellt. Dagegen erfolgt bei einem 0-Bit kein Wechsel. Auch hier ist eine geringe Modulationsrate realisierbar, allerdings können ebenfalls Fehler bei der Synchronisation auftreten, da der Signalübergang beziehungsweise die Taktung nicht immer eindeutig erkennbar ist.

Manchester

Zur besseren Unterscheidung einer Bitfolge wird bei diesem Verfahren ein Bit in zwei Phasen unterteilt beziehungsweise durch zwei Signale dargestellt (Selbsttaktung): 0-Bit (Low-Signal/High-Signal); 1-Bit (High-Signal/Low-Signal).

Wenn nun über einen gewissen Zeitraum kein Signalwechsel erfolgt, ist eindeutig erkennbar, dass ein Fehler aufgetreten ist. Insofern kann es bei maximaler Fehlererkennung zu keinen Synchronisationsproblemen kommen. Allerdings ist die Modulationsrate aufgrund der zweifachen Signalwechsel entsprechend doppelt so hoch, obwohl nur die Hälfte der übertragenen Bits tatsächlich genutzt werden.

Die Codierung, Übertragung, Decodierung und Wiedergabe von Videodaten ist je nach Qualitätsanspruch und Verfahren relativ zeitaufwändig. Dieser Zeitraum der Digitalisierung wird auch Latenz genannt. Insofern kommt es gegenüber der analogen Fernsehsignalübertragung beim DTV zu Verzögerungen, die mehrere Sekunden in Anspruch nehmen können. Bei flächendeckendem Digitalempfang fällt die zeitliche Differenz in der Ausstrahlung allerdings nicht mehr auf. Erkennbar war sie allerdings noch vor einiger Zeit, als über DVB-T bereits digital und über Kabel noch umfassend analog gesendet wurde. Im Jahre 2006 zur Fußballweltmeisterschaft in Deutschland fielen die Tore entsprechend mit geringen Verzögerungen – je nach Empfangsart.

SMPTE

Der SMPTE-Timecode wurde nach seinem „Erfinder“ benannt, der Society of Motion Picture and Television Engineers (SMPTE). Hierbei handelt es sich um einen geräteunabhängigen Synchronisationsstandard (ST 12-1/ST 12-2), der zuletzt im Jahre 2014 aktualisiert wurde. Anwendung findet der SMPTE-Timecode im Fernseh-, Hörfunk- und Studiobereich zur synchronen Aufnahme und Wiedergabe von Video- und Audiodaten, wobei die Zeitsteuerung heute vor allem in Tonstudios über Computer beziehungsweise spezielle Schnittstellen erfolgt.